Упали позиции сайта — 35 возможных причин падения сайта в поисковых системах Яндекс и Google

Не растут позиции сайта, сайт выпал из выдачи Яндекса — что делать и как быстро исправить ситуацию?

Упали позиции сайта в поисковиках — за этой фразой скрываются десятки возможных причин. Для многих бизнесов сайт является важным каналом привлечения клиентов, поэтому важно как можно скорее вернуть позиции сайта. Заодно вы сможете самостоятельно разобраться в причинах падения позиций, проконтролировать работу сеошника или SEO-компании.

Во-первых, мы сделали экспресс чек-лист, который позволит вам самостоятельно понять направление дальнейших действий — проверьте себя по нему. А далее мы описали 35 частых причин исчезновения сайта из результатов поиска поисковых систем и возможные их решения.Чек-лист проверки причин понижения позиций сайта в Яндексе или Google:

- Позиции и трафик упали во всех поисковых системах сразу. Налицо техническая проблема.

- Позиции упали только в одной поисковой системе, при этом сайт «вылетел» из выдачи практически полностью. Вероятно, попадание сайта под фильтр или даже в бан за какие-то нарушения. Нарушения эти могут быть настоящими (умышленными), а могут быть ложным срабатыванием алгоритма. Владельцу сайта, впрочем, от этого не легче, и проблему решать все равно нужно.

- Выпала только часть страниц/поисковых запросов. Вероятная причина — изменение алгоритмов. Либо формулы ранжирования (позиции объективно снизились после формирования выдачи по новым правилам), либо формул наложения фильтров (сайт имел нарушения, но раньше поисковая система «закрывала глаза» на эти недочеты).

- Упали позиции, но трафик сохранился. Или наоборот, позиции на месте, а трафик просел. Требуется глубокий анализ статистики по сайту. Сезонное проседание, отличия в выдаче для ПК и мобильных устройств, иные причины.

- Позиции снижаются медленно, но верно. Обычно это означает, что конкуренты потихоньку опережают вас в качестве. Но бывает и так, что есть негативные причины или нарушения, которые тянут сайт вниз.

«Мы никаких работ не проводили в последние полгода, откуда фильтр?!» Не следует удивляться, вполне стандартная ситуация. Нарушения могли присутствовать на сайте длительное время, а потом в какой-то момент вызвать наложение фильтра. Сайтов (причем качественных сайтов) с каждым днем появляется все больше, а фильтры становятся жестче. Кроме того, фильтр мог быть наложен в результате внешних действий, в т.ч. недобросовестной конкуренции.

Далее мы рассмотрим 35 причин падения позиций сайта. Некоторые из них очевидны и могут быть легко исправлены самостоятельно. В других случаях потребуется привлечение специалистов.

Причины ухудшения позиций сайта можно разбить на 7 направлений

| Смена алгоритма | Новые технологии и стандарты качества | Технические проблемы |

| Неверная внутренняя оптимизация | Внешние причины | Действия злоумышленников |

| Нечестные методы заработка |

Самой частой причиной выпадения сайта из индекса являются технические проблемы на стороне сервера. Но начнем мы не с них — они обычно очевидны и легко устраняются — а с более редких и сложных причин, которые мы диагностируем, проводя комплексный анализ сайта.

Смена алгоритма поисковых систем

Первая группа факторов — смена алгоритма поисковой системы. Тут выход только один — изучать новые условия и подстраиваться под них. Главная сложность — установить, что падение позиций вызвано именно новыми правилами ранжирования.

1. Изменение алгоритма ранжирования

Как узнать о запуске нового алгоритма:

- Сравниваем текущую выдачу с той, что была несколько дней/недель назад. Если налицо серьезные изменения, а из ТОП-10 вылетели 5-6 прежних лидеров, то вероятно дело не в вашем сайте, а в новых правилах ранжирования.

- Не всегда, но Яндекс анонсирует запуск значительных изменений, следите за новостями.

- Зайдите на активные форумы вебмастеров, все значимые нововведения активно обсуждаются в Интернете. Возможно, там уже есть ответ на ваши вопросы.

*** Откуда можно получить «старую» выдачу? Если вы регулярно делали замеры позиций, то прежние варианты у вас будут. Если не делали, то взять ее неоткуда.

2. Изменение типа запроса

Все запросы делятся на коммерческие и информационные, выдача по ним формируется по-разному. Бывает, что запрос меняет свой тип. Например, «облицовочный камень» — это про продажу конкретного строительного материала (коммерция) или обзорные статьи про разные виды камня (информация)?

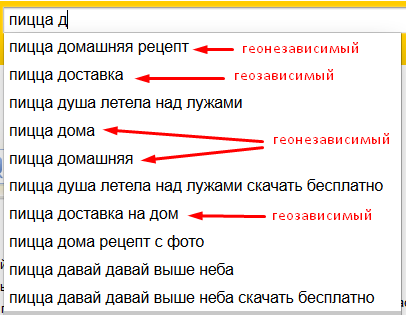

3. Изменение геозависимости

Бессмертная классика: «рецепт пиццы» запрос геоНЕзависимый, а «доставка пиццы» привязана к конкретному городу.

Сейчас все больше и больше услуг уходит в онлайн, поэтому «привязка к местности» теряет свое значение. Пример: «репетитор по математике». Ранее репетиторов всегда искали очно, сейчас же занятия часто проводятся по Скайпу, и местоположения наставника не имеет значения.

Пункты 2-3 вызывают не проседание сайта в целом, а изменение позиций по отдельным запросам. Причем не только у вас, но и у ваших конкурентов из ТОП-10, т.е. меняется выдача в целом.

4. Смена типа сайта коммерческий -> информационный

Деление на информационные и коммерческие действует не только на запросы, но и на сайты. У вас интернет-магазин, при котором дополнительно запущен информационный блог, или же блог — главная составляющая проекта, а продажи с сайта лишь способ монетизации.

При прочих равных «коммерческий» сайт будет ранжироваться выше «информационного» по продающим запросам. Обратное также верно.

Если Яндекс некорректно определил тип вашего проекта, то придется поработать над развитием основного направления.

Понять, что проседание позиций связано именно с этой причиной, поможет детальный анализ и сравнение трафика до/после возникновения проблем. Увидим снижение визитов по одному типу запросов, и рост по другому.

Возможна также «странная» на первый взгляд ситуация: снижение продаж при сохранении и даже увеличении трафика.

Новые тренды

В 2022 году Яндекс запустил новые метрики: Проксима, Профицит и Антикачество. Кроме того, следует придерживаться современных стандартов качества сайта: использовать адаптивный дизайн и безопасный протокол https.

Отступление от этих норм не приводит к выпадению сайта из поиска, но вызывает долговременное стабильное снижение позиций и трафика.

5. Репутация сайта

Ссылочное цитирование — один из краеугольных камней SEO-продвижения. Поисковые системы стараются снижать влияние этого фактора, т.к. он поддается манипулированию, но полностью отказаться от него не могут.

Ранее любая ссылка с хорошего «трастового» ресурса помогала продвижению. Теперь же Яндекс определяет смысл и контекст страницы. Если это сайт с отзывами, а отзыв негативный, то такая рекомендация сработает в минус.

Учитывайте, что Яндекс прекрасно увязывает название компании/продукта с сайтом, т.е. собственно веб-ссылка даже и не обязательна, отзыв будет в любом случае засчитан. Например, проверьте отзывы о сайте в Яндекс.Браузере.

Решение проблемы: работать с отзывами и формировать положительную репутацию. Мы можем сделать бесплатный поиск отзывов о вашей компании, после чего станет понятно, как они влияют на позиции сайта и нужно ли заниматься управлением репутацией системно.

6. Адаптивный дизайн

Мобильные устройства уже приносят более половины трафика. Сайты, не имеющие адаптивного («резинового») дизайна, не попадают в выдачу Яндекса для мобильных устройств (она отличается от выдачи для ПК).

Это приводит к потере значительной части трафика, а также постепенному общему снижению позиций. Устаревший дизайн = нет заботы об удобстве посетителей = позиции вниз.

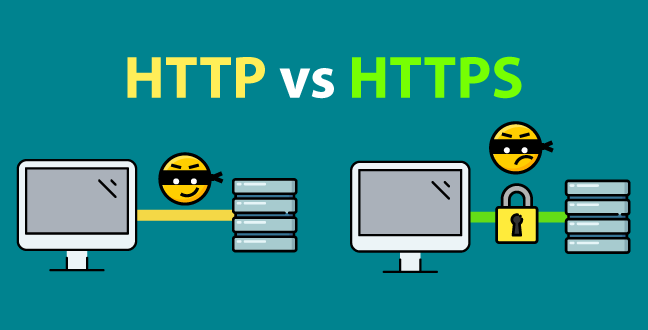

7. Использование устаревшего http вместо https

И Гугл и Яндекс прямо рекомендуют сайтам использовать защищенный https протокол. И это относится не только к коммерческим проектам, принимающим оплату онлайн, но и вообще к любым ресурсам, даже чисто информационным.

Использование протокола https является фактором ранжирования.

Переезд с http на https не сложен, но требует определенных навыков, чтобы избежать ошибок и временного выпадения сайта из выдачи.

Технические проблемы на сайте

Самой частой причиной резкого проседания позиций остаются технические проблемы.

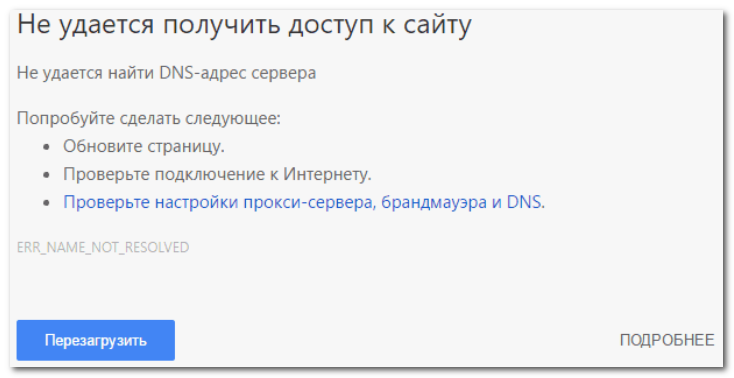

8. Недоступность сайта

Недоступность сайта приводит к тому, что он полностью выпадает из индекса поисковых систем. Причин недоступности может быть множество: забыли оплатить хостинг, «упали» сервера хостинг-провайдера, DDoS-атака и т.д.

Как правило, если вы успели вовремя отреагировать, последствия будут кратковременными. Сайт вернется на прежние позиции после переиндексации.

Саму переиндексацию можно частично ускорить, отправив запросы через Панели вебмастера Яндекса и Гугла.

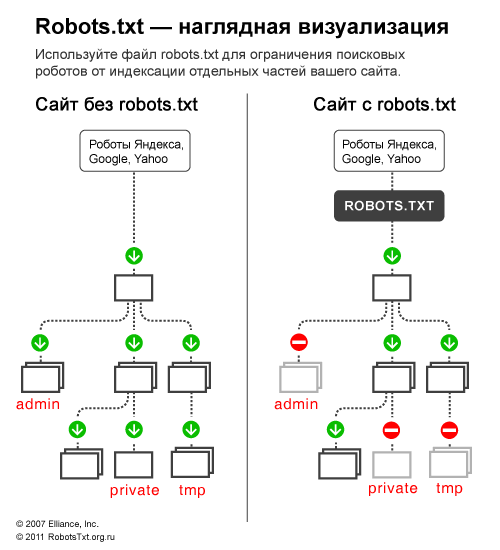

9. Запрет на индексацию в Robots.txt

Robots.txt позволяет закрыть от индексирования часть страниц на сайте. Это необходимо для исключения из индекса технических страниц, которые в огромном количестве содержат CMS (системы управления сайтам). Но одно неосторожное движение — строка Disallow: / — запретит индексацию всего сайта целиком.

Скажете, что этот совет слишком очевидный? Согласимся, но такое бывает, и не так чтобы редко.

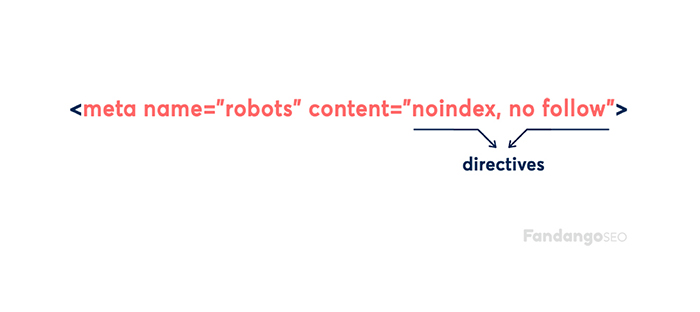

10. Запрет на индексацию в meta robots

Мета-тег «meta robots», прописанный в html-коде страницы, также может запрещать индексацию.

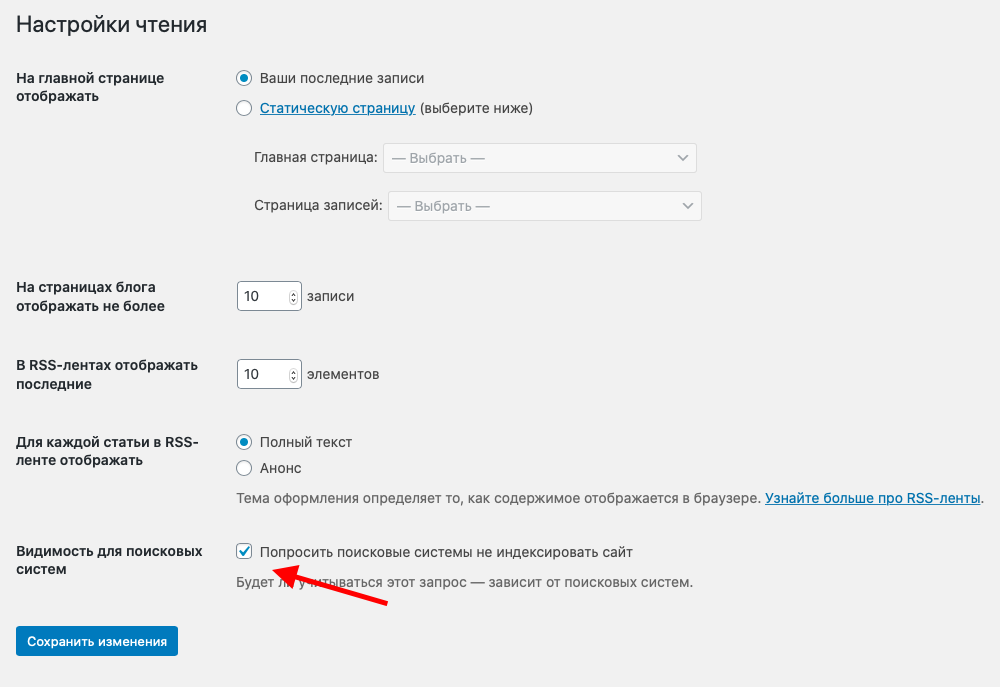

11. Запрет индексации через интерфейс CMS

А еще непосредственно в самих CMS могут быть настройки, разрешающие/запрещающие индексацию. Удобно, если вебмастер знает о наличии этих функций и понимает их использование.

12. Блокировка IP адреса поискового робота на стороне хостинга

Нечасто, но приходится сталкиваться и с такой проблемой. «Кривые» настройки защиты сервера приводят к блокировке поисковых роботов, ведь они скачивают сайт целиком, создавая большую нагрузку.

В этом случае сайт прекрасно доступен при ручном просмотре из браузера, но не может быть проиндексирован поисковыми системами.

Предупреждение об этом обязательно появится в панелях вебмастера.

13. Переезд на другую CMS

Смена дизайна, переход на новую CMS, изменение структуры сайта часто приводит к тому, что часть страниц меняют свои адреса.

Для того, чтобы не получить проседания в позициях и не потерять накопленную ссылочную массу, следует обязательно прописывать 301 редирект.

Эта настройка скажет Яндексу и Гуглу, что страница не просто исчезла, а переехала на постоянный новый адрес. Посетители, перешедшие на несуществующую страницу (из поиска, либо по ссылкам), также не будут потеряны.

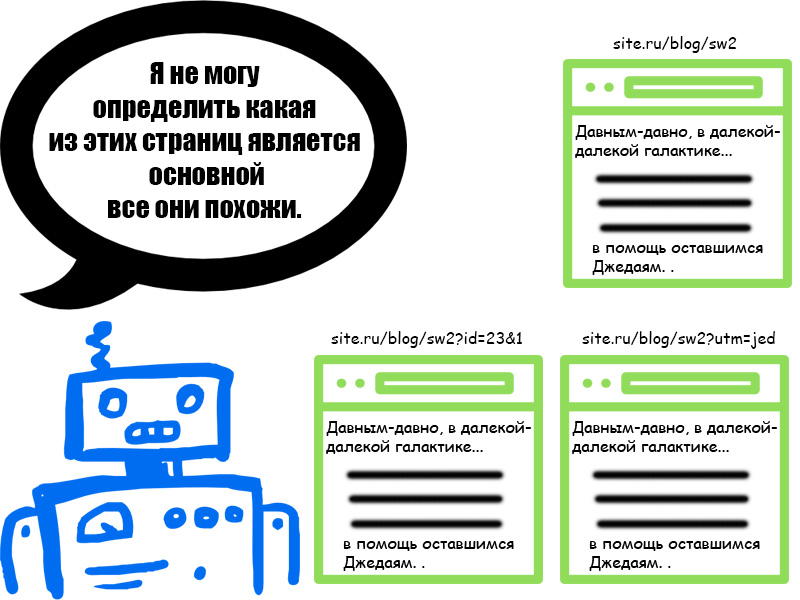

14. Дубли страниц

Современные CMS создают огромное количество технических дублей страниц. Иногда одна страница может быть доступна чуть ли не по десятку разных адресов.

site.ru/catalog/page

site.ru/catalog/page/

site.ru/catalog/page.html

www.site.ru/catalog/page

www.site.ru/catalog/page.html

+ версии страницы «для печати», «упрощенный просмотр» и т.д.

Для поисковых систем все эти адреса разные. И хотя Яндекс и Гугл неплохо научились определять дубли, лучше не пускать это дело на самотек и самостоятельно закрыть технические страницы в robots.txt.

В некоторых случаях удобнее использовать тег «rel canonical», который сообщает роботу адрес исходной, «оригинальной» страницы, которая и должна оказаться в индексе.

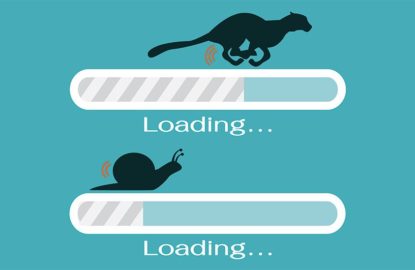

15. Скорость загрузки страниц

Этим пунктом мы завершаем список технических проблем, хотя по важности его стоило бы поставить на первое место. Очень «подлая» неполадка, которую бывает трудно диагностировать.

Речь не идет о «тормознутых» сайтах, где загрузку страницы приходится ждать по минуте. Бывают сайты, которые визуально работают вполне быстро, но при этом все же проигрывают конкурентам по скорости. А это один из значимых факторов ранжирования.

На скорость работы влияет множество причин: загруженность хостинга, настройки CMS, скорость работы скриптов, оптимизация изображений и т.д.

Проверить скорость сайта можно в инструменте Google Page Speed Insights. Нужно обязательно находится в «зеленой зоне». В противном случае следует провести технический аудит и оптимизацию сайта.

Внутренняя оптимизация сайта

Следующий блок проблем связан с внутренней оптимизацией сайта: текстами, дизайном, html-кодом.

16. Одинаковые сниппеты

Для Интернет-магазинов характерно наличие огромного количества схожих товаров. 30 брендов чайников, у каждого из которых по 10 моделей, каждая из которых представлена в 5 цветах.

Под каждый чайник создается отдельная карточка товара, отдельная страница. При этом описание, тег Title и мета-тег description остаются одинаковыми для всех страниц.

Эта недопустимая ситуация должна быть обязательно исправлена, иначе падение позиций не за горами.

17. Переоптимизация

Избыточное использование ключевых слов может привести к пессимизации страницы или всего сайта.

Следует отметить, что все эти подсчеты «плотности текста», «количества точных и разбавленных вхождений» остались в далеком прошлом. Поисковые системы отлично умеют определять смысл страницы, поэтому тексты можно писать живым естественным языком. А ключевые слова достаточно употребить в тексте столько раз, сколько это подходит по смыслу + использовать их в Title и заголовках.

Снижение позиций из-за seo-текстов как раз часто вызывает вопрос: «Но ведь раньше все хорошо было». Раньше было, а сейчас Яндекс решил улучшить качество поиска, и ваш сайт пошел под фильтр.

Решение: проверить тексты и переделать явно seo-шные статьи.

18. Фильтр «Ты последний»

Фильтр накладывается за использование неуникальных текстов. Тут следует сделать оговорку, что текстовых фильтров существует огромное множество. «Ты последний» — очень старый фильтр и мы просто взяли это название, чтобы поговорить про качество текстов.

Раньше для успешного продвижения достаточно было сделать «глубокий рерайт», т.е. получить формально уникальный текст. С приходом нейронных сетей и искусственного интеллекта Яндекс научился понимать смысл написанного. Поэтому рерайт, даже самый качественный, не спасает.

Если статья не несет в себе какой-то действительно новой и реально полезной информации, то вероятность выхода в ТОП очень невелика.

19. Фильтр АГС

Яндекс официально не расшифровывал аббревиатуру АГС. Поэтому по сети ходит две версии: «автоматический гранатомет станковый» (которым Яндекс «выжигает» некачественные ресурсы) и более народное «антиго**осайт».

Чтобы получить АГС нужно постараться, но иногда такое случается. Фильтр накладывается за очень низкое качество сайта — чужие тексты, неудобный дизайн, полное отсутствие какой—либо полезной информации.

Решение: необходимо провести работы по реальному улучшению сайта.

20. Назойливая реклама

К назойливой рекламе можно отнести следующие виды:

- Pop-up — всплывающие окна с рекламой.

- Pop-under — вместе с сайтом открывается еще одна страница брауезра с рекламируемой страницей.

- Click-under — отдельное рекламное окно открывается при первом клике на странице основного сайта.

Такая реклама — явное неуважение к пользователю и показатель низкого качества сайта.

21. Обилие рекламы

Само по себе обилие рекламы не является нарушением и не влияет на позиции, если реклама органично встроена в дизайн страниц и не мешает просмотру основного контента.

Но иногда встречаются явные перегибы, когда реклама опубликована чуть ли не через каждый абзац. Такие сайты часто теряются позиции.

Наше предположение — это происходит не из-за штрафных санкций, а из-за естественного ухудшения поведенческих факторов. Людям просто не нравятся такие сайты.

22. Обман с push-уведомлениями

Push-уведомления — сообщения сайта, которые будут показаны в браузере пользователя. Не является нарушением, если посетитель сам подписался на них. Штрафные санкции будут наложены, если:

- Подписка была получена обманным путем.

- Без подписки блокируется доступ к основному содержимому сайта.

- Предложения о подписке поступают многократно.

23. Продажа ссылок

Продажа и покупка ссылок — «серый» метод продвижения. Точнее, серый он для вебмастеров — совсем без ссылочного продвижения далеко не уедешь. А с точки зрения поисковых систем это однозначно «черное seo».

Фильтры могут быть наложены не только за покупку, но и за продажу ссылок. Если сайт зарабатывает столь сомнительным образом, то вряд ли его можно считать полезным.

Стоит отметить, что адекватное количество ссылок на схожие по тематике ресурсы вреда не принесут. А вот злоупотребление таким видом рекламы может привести к фильтру.

24. Дорвеи

Устаревший метод «черного» продвижения, но на всякий случай расскажем и про него. Заключается в создании большого числа страниц, которые не имеют самостоятельной ценности, а призваны перенаправить посетителя на некоторую другую страницу.

Фильтры за внешние действия над сайтом

Накрутка поведенческих факторов, покупка ссылок и другие запрещенные способы продвижения. Могут быть как действиями владельца сайта для быстрой раскрутки (и тогда вы знаете, за что прилетел фильтр), так и действиями конкурентов.

В случае обнаружения недобросовестной конкуренции следует писать в тех. поддержку Яндекса. К сожалению, это не дает 100% гарантии. Скорее всего вы получите шаблонный ответ в стиле: «Яндекс умный, про черную конкуренцию знает и умеет ее не учитывать». На деле же бывает по разному, но письмо все же должно помочь в случае возникновения проблем.

25. Фильтр за покупку ссылок (Минусинск)

Как и в случае с текстами, фильтров за покупку внешних ссылки несколько. Минусинск — наиболее известный, поэтому его и возьмем для обобщающего раздела.

Фильтры накладываются за «ссылочный взрыв» — появление слишком большого числа внешних ссылок сразу, а также и в целом за «плохую» ссылочную массу. Нужно понимать, что алгоритмы Яндекса, основанные на нейросетях, прекрасно определяют покупные ссылки.

Практический опыт показывает, что качественные ссылки отлично работают при продвижении сайта и не вызывают проблем. Ресурс должен быть трастовый, совпадающий по тематике и дающий хотя бы минимум живых переходов.

Другими словами, лучше купить одну хорошую ссылку, чем 10 слабеньких.

При наложении фильтра следует максимально почистить ссылочную массу. Не всегда это легко сделать (многие сайты могут просто не ответить), но обычно после определенных усилий удается вывести сайт из-под фильтра.

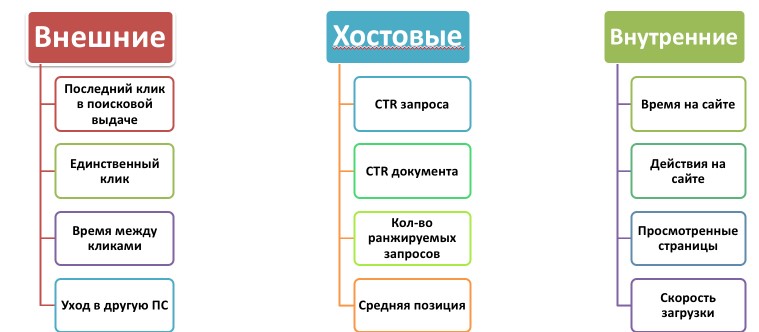

26. Накрутка поведенческих факторов

Поведенческие факторы — группа метрик, которые характеризуют впечатление пользователя. Время просмотра сайта в целом и отдельных страниц в частности, глубина просмотра, количество «отказов» (быстрое закрытие страницы), добавление сайта в закладки, повторные визиты и прочие.

Анализ поведенческих позволяет поисковой системе понять, что сайт действительно нравится людям. А ведь это самая главная и самая надежная рекомендация.

Накрутку поведенческих факторов можно осуществлять как с помощью специальных программ, так и с помощью постановки заданий живым исполнителям через специальные биржи. За символическую плату «школьники» забьют в поиске ключевое слово, перейдут на ваш сайт и выполнят на нем ряд обозначенных действий, имитируя пользовательский интерес к ресурсу.

Оба способа легко распознаются поисковиками. Алгоритмы искусственного интеллекта знают о нас больше, чем нам кажется. Смартфоны с геолокацией, история запросов, история посещенных сайтов и другие параметры позволяют с высокой точностью сформировать «портрет пользователя» — пол, возраст, социальное положение и т.д. Любая непривычная активность будет обнаружена.

Очень жесткий и сложный для снятия фильтр. Необходимо остановить накрутку и связаться с технической поддержкой. Ориентировочный срок снятия — 6 месяцев.

27. Искусственное «улучшение» ПФ

Возьмем для примера такой показатель, как «глубина просмотра». Большое число просмотренных страниц обычно свидетельствует о качестве и интересности сайта.

Но можно искусственно выстроить логику и структуру сайта таким образом, чтобы посетитель не мог найти ответ на первой же странице, а вынужден был совершить несколько дополнительных переходов. Получаем формальное улучшение ПФ — глубины просмотра и времени, проведенного на сайте.

Такие методы реально работали в прошлом, но сейчас Яндекс умеет определять качество сайтов различными дублирующими друг друга способами, и такие попытки «улучшения» вызовут скорее обратный эффект.

За совсем жесткие формы издевательства над посетителями можно получить фильтр. Вот как сам Яндекс описывает условия наложения:

Иногда подобный обман осуществляется с помощью обычных пользователей интернета, которых вынуждают имитировать реальные посещения какого-либо сайта из результатов поиска. Например, посредством специальной капчи, пройти которую необходимо, задав указанный запрос и кликнув по указанному адресу сайта.

Ориентировочный срок снятия фильтра — 1 месяц после устранения нарушения.

28. Порноссылки

Метод черной конкуренции. Размещение на сайт ссылок с порно-ресурсов способно быстро загнать проект в бан. Методы борьбы — обращение в тех. поддержку. В данном случае шансы получить положительный ответ велики, ведь очевидно, что владелец подобным «продвижением» заниматься не будет.

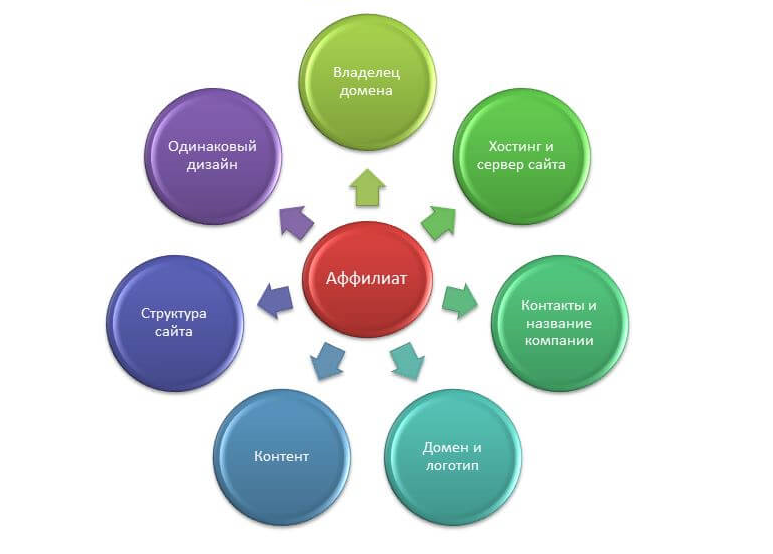

29. Аффилиат-фильтр

Если Яндекс определит, что компании принадлежат два и более схожих ресурса, то будет наложен аффилиат-фильтр.

Разные сайты, разный дизайн, уникальные тексты — но при этом один владелец и одинаковый ассортимент продукции. Можно сделать вывод, что второй (пятый, десятый) сайт создан только для привлечения дополнительного поискового трафика (попытка занять несколько мест в поиске) и не несет никакой реальной дополнительной ценности.

Аффилиат-фильтр работает таким образом, что в выдаче будет показан только один из сайтов. Т.е. это не штраф в полной мере, а вполне разумное и честное ограничение.

Однако, бывает что аффилиат-фильтр склеивает конкурирующие сайты — и эту проблему нужно решать.

Проверить на аффилиат можно следующим путем:

- Формируем список сайтов из ТОП-20 выдачи Яндекса.

- Последовательно делаем поиск по некоторому ключевому запросу, дополняя его конструкцией —site1, —site2 и т.д.

Т.е мы просим систему исключить из выдачи страницы site1, site2 и т.д. В случае аффилиат-фильтра в какой-то момент на месте исключенного siteN появится наш ресурс. Если это произошло — факт «склейки» двух сайтов установлен.

Исправление ошибки — через тех. поддержку.

Действия злоумышленников

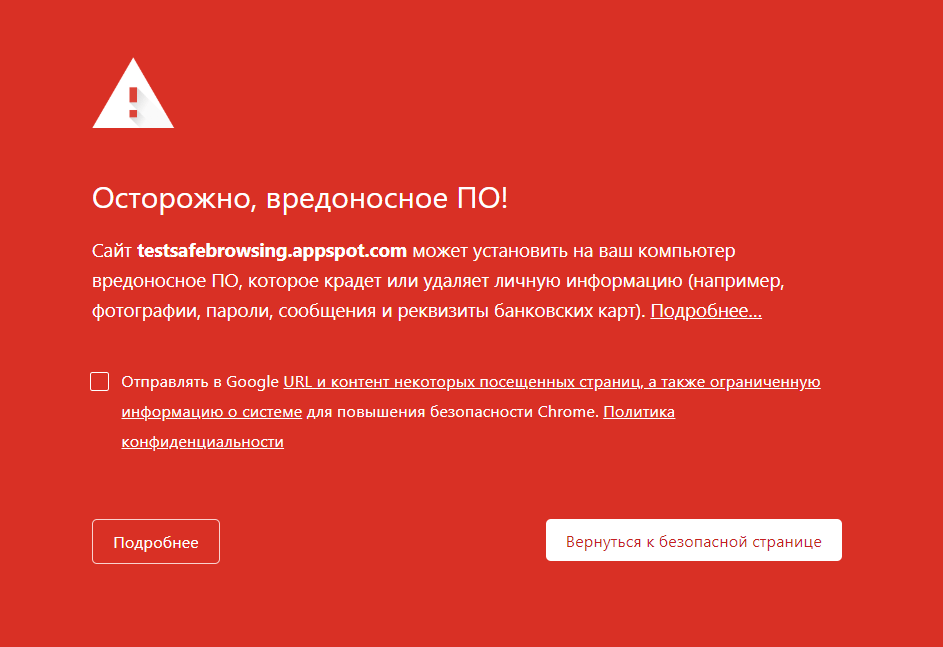

Взлом сайта превращает его в опасный инструмент противоправных действий. Логично, что такой ресурс будет исключен из поиска.

Иногда вместо исключения в выдаче появляется предупреждение «Сайт может представлять угрозу». Или же сам браузер предотвращает посетителя от доступа к опасному ресурсу.

Все это вызывает радикальное проседание трафика, а затем и позиций.

30. Взлом сайта

Взлом сайта осуществляется либо путем хакерских атак, либо в результате использования взломанных плагинов и дополнений. Попытка сэкономить на покупке официальной версии продукта часто приводит к плачевным последствиям.

Опасные компоненты обычно проявляют себя не сразу, а исправно работают в течение нескольких месяцев. И только потом начинаются «сюрпризы» в виде массовых рассылок спама и других неприятностей.

А установить причину непрофессионалу достаточно сложно. Ведь на первый взгляд нет никакой связи между взломом и установленным полгода назад «бесплатным» плагином.

Правильный выход — заказать «чистку» сайта у профессионалов, самостоятельно справиться с проблемой смогут далеко не все.

31. Вирусы на сайте

Все как в предыдущем пункте, только сайт будет атаковать компьютеры посетителей.

32. Опасные файлы

Такое предупреждение возникает в случае, если сам сайт не несет непосредственной угрозы, но предлагает скачать и установить потенциально опасные программы, расширения, дополнения и т.д.

Если вы не занимаетесь ничем подобным, то следует разобраться, каким образом опасное ПО попало на ваш ресурс (вероятно, опять-таки через взлом).

Нечестные методики заработка на сайте

Есть ряд «серых» методов монетизации сайта, когда ресурс вроде бы не наносит вреда посетителям, но все же использует их компьютеры без ведома владельцев. Ваш сайт может быть заражен такого рода скриптами, или люди, у кого был доступ к сайту могут скрытно использовать его.

33. Майнинг криптовалют

На сайте размещается скрипт, который использует компьютер посетителя для майнинга. Естественно без разрешения. Такое поведение — повод для наложения фильтра.

34. Кликджекинг

Кликджекинг — мошенническая техника, заставляющая пользователя незаметно для себя выполнить некоторые действия.

Техническая реализация выглядит следующим образом: поверх основной (видимой) страницы располагается невидимый слой, в который загружается нужная злоумышленнику страница. Загрузка осуществляется таким образом, что некоторый элемент управления (кнопка, ссылка) на невидимой и видимой страницах совпадают.

Посетитель делает клик по видимой кнопке, но при этом совершает действие на стороннем сайте, даже не подозревая об этом.

Кликджекинг может применяться для разных целей, начиная от достаточно безобидных и заканчивая совершенно преступными.

Чаще всего он используется для идентификации соц. сетей посетителя, что впоследствии позволяет рассылать «тематическую» рекламу. Но может использоваться и для получения личной информации, номеров телефона, паролей и даже совершения покупок в интернете.

Кликджекинг является частым следствием взлома сайта злоумышленниками.

Важно! В сети есть ряд сервисов, которые предлагают услуги идентификации пользователей — тот самый «мягкий» вариант кликджекинга. Вы получаете ссылки на профили ваших посетителей в социальных сетях. Данные можно использовать для рекламы, личного обращения, индивидуальных скидок и т.д. Вроде бы очень полезная информация, только добывается она нечестным путем, который может привести к санкциям против вашего сайта.

35. Опасное перенаправление

Страница содержит редирект и перенаправляет посетителя (в т.ч. из поиска) на сторонний ресурс, не связанный с сайтом.

Обычно такие редиректы появляются в результате взлома.

Упали позиции сайта? Закажите аудит в компании Exiterra

Для быстрого решения проблем с сайтом стоит заказать бесплатный экспресс аудит в компании Exiterra и услуги по возвращению позиций сайта в ТОП. Быстро поможем определить причины проседания позиций сайта, выйти из-под фильтра и вернуть утраченную посещаемость.

SEO-оптимизация сайта – на 20% дешевле!

Ваш сайт может приносить больше клиентов. Мы знаем, как этого добиться. Закажите услугу «Создание потока заявок с SEO и оплатой за лиды» со скидкой 20% и платите только за результат.

Остались вопросы?

Бесплатная консультация по продвижению вашего бизнеса или сайта.

Лучшие статьи

- Работа с отзывами в 2025 году: топ-7 главных инсайтов

- Черный пиар на Яндекс Картах: кто пишет отрицательные отзывы и можно ли с этим бороться?

- Почему конверсия в вашей воронке продаж низкая: 5 причин

- Стратегия крауд-маркетинга: как разработать и реализовать

- Как привлечь туристов в новый ботанический сад, если на рекламу нет денег

Оставьте свой номер телефона и мы свяжемся с Вами в рабочее время.